Trong vài năm gần đây, AI tạo sinh đã bước rất nhanh vào môi trường doanh nghiệp. ChatGPT được nhiều nhân sự xem như một “trợ lý số” giúp tăng tốc công việc hằng ngày. Tuy nhiên, đằng sau sự tiện lợi đó là những rủi ro từ ChatGPT mà nhiều tổ chức chưa đánh giá đầy đủ.

Bài viết này sẽ giúp doanh nghiệp hiểu rõ bản chất rủi ro và cách phòng tránh rò rỉ dữ liệu từ ChatGPT một cách thực tế. Trọng tâm không nằm ở cấm đoán, mà ở kiểm soát thông minh và có hệ thống.

AI tạo sinh mang lại giá trị gì cho doanh nghiệp?

Không thể phủ nhận AI tạo sinh đang cải thiện năng suất làm việc rõ rệt. Nhân viên có thể soạn thảo nhanh, tóm tắt nội dung, hoặc hỗ trợ phân tích kỹ thuật hiệu quả hơn. Trong môi trường áp lực cao, ChatGPT trở thành công cụ quen thuộc của nhiều bộ phận. Từ IT, kỹ thuật, marketing, đến vận hành, ai cũng có lý do để sử dụng AI.

Vấn đề nằm ở chỗ, các hệ thống AI xử lý dữ liệu dựa trên đầu vào từ người dùng và không có khả năng tự nhận biết đâu là dữ liệu công khai hay dữ liệu nhạy cảm của doanh nghiệp. Nếu không kiểm soát, chính thói quen “tiện tay copy và paste” sẽ tạo ra lỗ hổng nghiêm trọng.

Rủi ro từ ChatGPT không chỉ đến từ công nghệ

Các dịch vụ AI như ChatGPT hay Google Bard đang ngày càng phổ biến trong doanh nghiệp. Đồng thời, những nền tảng này cũng có thể bị tội phạm mạng lợi dụng để hỗ trợ các kịch bản tấn công. Điều này làm gia tăng rủi ro an ninh mạng cho tổ chức.

Một rủi ro khác ít được chú ý hơn nhưng đặc biệt nghiêm trọng là hành vi của người dùng cuối. Nhân viên có thể vô tình làm lộ tài sản trí tuệ hoặc bí mật nội bộ khi sử dụng AI. Khi dữ liệu được nhập vào ChatGPT, dữ liệu đó đã rời khỏi vùng kiểm soát của doanh nghiệp.

Khi “không lưu dữ liệu” vẫn chưa đủ an toàn

Nhiều dịch vụ AI tuyên bố rằng họ không lưu trữ (cache) hoặc không sử dụng dữ liệu người dùng gửi lên để huấn luyện mô hình. Tuy nhiên, các sự cố từng xảy ra với ChatGPT đã cho thấy hệ thống AI vẫn có thể tồn tại lỗ hổng kỹ thuật nhất định.

Những lỗ hổng này có thể dẫn đến việc:

- Lộ tài sản trí tuệ của doanh nghiệp

- Lộ prompt truy vấn và phản hồi của người dùng

- Gây rủi ro nghiêm trọng cho dữ liệu nhạy cảm

Chính vì vậy, ngày càng nhiều tổ chức đặt ra câu hỏi: Làm thế nào để tận dụng AI mà vẫn kiểm soát được dữ liệu nội bộ?

Các kịch bản rò rỉ dữ liệu phổ biến qua ChatGPT

Trong thực tế, việc rò rỉ dữ liệu qua AI thường xuất phát từ những thao tác rất quen thuộc:

- Nhân viên đưa ghi chú họp nội bộ về sản phẩm mới vào ChatGPT để tạo bản tóm tắt cho lãnh đạo.

- Lập trình viên copy mã nguồn quan trọng vào ChatGPT để xin gợi ý cải tiến.

- Kỹ sư vận hành dán log hệ thống chứa username, IP, hoặc tên hệ thống vào ChatGPT để viết báo cáo phân tích nguyên nhân sự cố.

Trong tất cả các trường hợp trên, dữ liệu đã rời khỏi vùng kiểm soát nội bộ của doanh nghiệp ngay khi được đưa vào nền tảng AI. Trước những rủi ro này, doanh nghiệp cần một cách tiếp cận kỹ thuật để kiểm soát việc dữ liệu bị đưa ra ngoài thông qua các nền tảng AI như ChatGPT.

Vai trò của Data Loss Prevention trong kiểm soát rủi ro từ ChatGPT

Để kiểm soát rủi ro từ ChatGPT, doanh nghiệp cần xem AI như một kênh xuất dữ liệu mới. Cách tiếp cận này tương tự như khi doanh nghiệp từng quản trị email, web hoặc cloud. Trellix Data Loss Prevention (DLP) được thiết kế để giám sát và bảo vệ dữ liệu ở hai lớp quan trọng:

- Endpoint – nơi người dùng thao tác trực tiếp với dữ liệu

- Network – nơi dữ liệu được truyền ra ngoài hệ thống

Cách tiếp cận này giúp doanh nghiệp kiểm soát dữ liệu ngay từ điểm phát sinh, thay vì chỉ xử lý khi dữ liệu đã rời khỏi hệ thống.

Triển khai Trellix DLP cho kịch bản ChatGPT

Trellix DLP cung cấp bộ rule template dựng sẵn, cho phép doanh nghiệp triển khai DLP nhanh chóng mà không cần xây dựng toàn bộ chính sách từ đầu. Với các dịch vụ AI như ChatGPT hay Google Bard, việc xây dựng rule cần thiết có thể thực hiện chỉ trong vài phút. Sau khi tạo rule, doanh nghiệp có thể thử nghiệm, tinh chỉnh và áp dụng trong production.

Ba nhóm rule DLP chính để phòng tránh rò rỉ dữ liệu từ ChatGPT

- Clipboard Protection: Giám sát hoặc chặn việc sao chép dữ liệu nhạy cảm qua clipboard.

- Web Protection: Giám sát dữ liệu được đăng hoặc tải lên website

- Application Control: Giám sát hoặc chặn truy cập tới website

Bước chuẩn bị bắt buộc: Tạo Definitions trong Trellix ePO

Trước khi xây dựng rule, doanh nghiệp cần tạo các definitions để tái sử dụng trong nhiều rule khác nhau.

Đường dẫn thao tác:

Trellix ePolicy Orchestrator (ePO) → DLP Policy Manager | Definitions

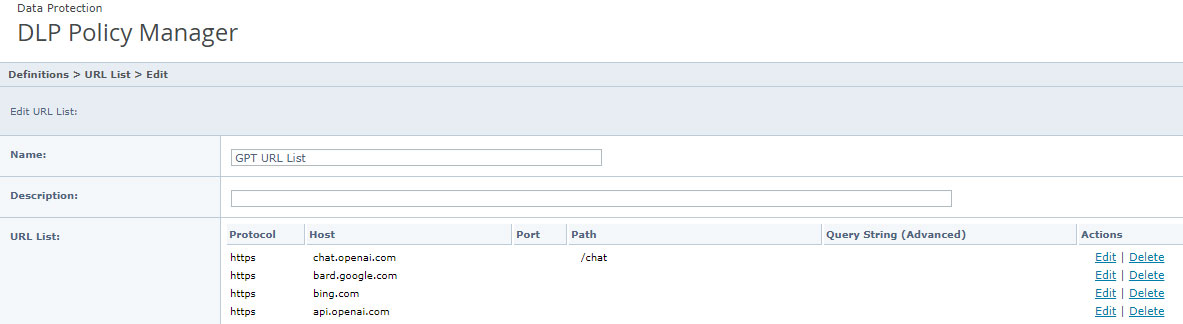

1. Tạo URL List (Destination URL)

URL List được sử dụng trong web protection rule và web content fingerprinting classification.

Các URL AI sẽ tập trung gồm:

- ChatGPT: https://chat.openai.com

- Google Bard: https://bard.google.com

- Bing AI: https://bing.com

- ChatGPT API: https://api.openai.com

- Các nền tảng LLM khác theo nhu cầu doanh nghiệp

Hình 1: Định nghĩa DLP cho danh sách URL

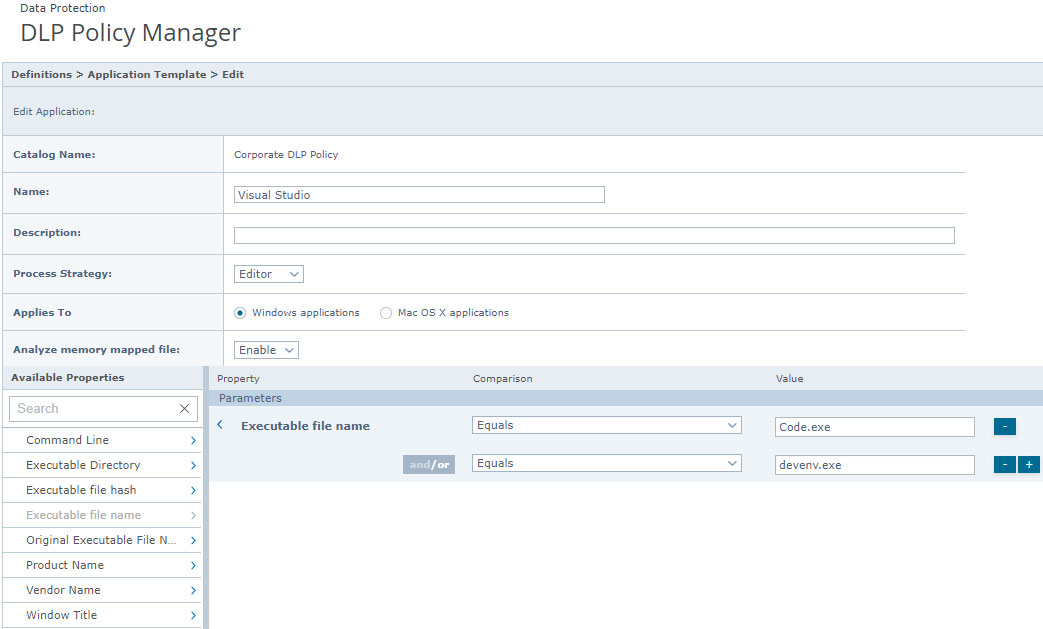

2. Tạo Application Template (Source Application)

Application Template dùng để nhận diện ứng dụng nguồn phát sinh dữ liệu.

Chúng ta sẽ tập trung vào:

- Visual Studio – devenv.exe

- Visual Studio Code – Code.exe

Hình 2: Định nghĩa DLP cho Application Template

Xây dựng rule set “GPT Monitoring and Blocking”

Sau khi hoàn tất definitions, doanh nghiệp tạo một rule set mới trong DLP Policy Manager, đặt tên “GPT Monitoring and Blocking”, rồi triển khai các rule mẫu dưới đây. Tất cả rule cần được test kỹ trong môi trường kiểm soát trước khi áp dụng diện rộng.

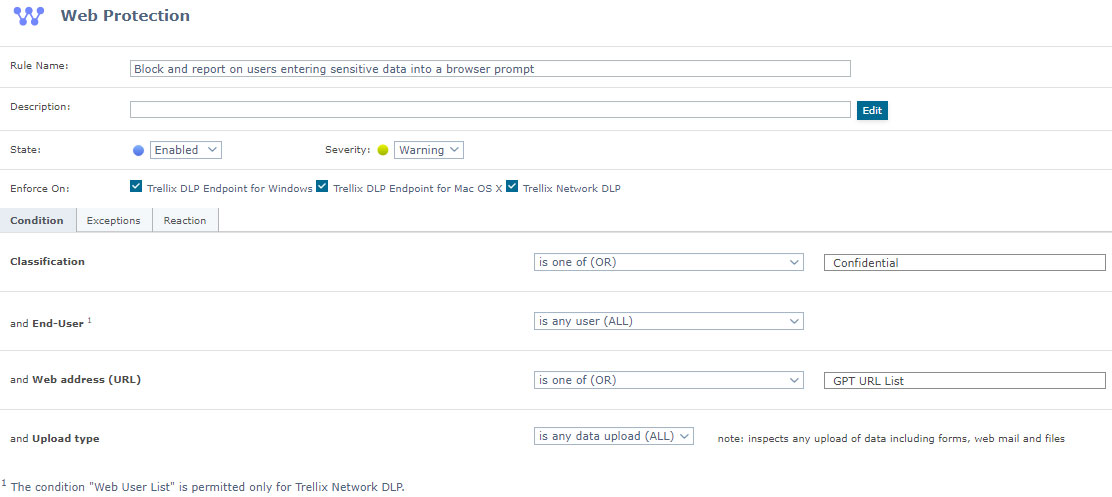

A. Giám sát người dùng nhập dữ liệu nhạy cảm vào prompt trình duyệt

- Loại rule: Web Protection

- Enforced On: Windows và Network (macOS chỉ hỗ trợ reporting)

- Hiện chỉ hỗ trợ chặn trên Firefox; Chrome và Edge chỉ ghi nhận

- Classification: nội dung nhạy cảm cần giám sát

- End-User: All

- Web Address (URL): GPT URL List

- Upload Type: All

Hình 3: Quy tắc DLP để giám sát các lời nhắc trình duyệt

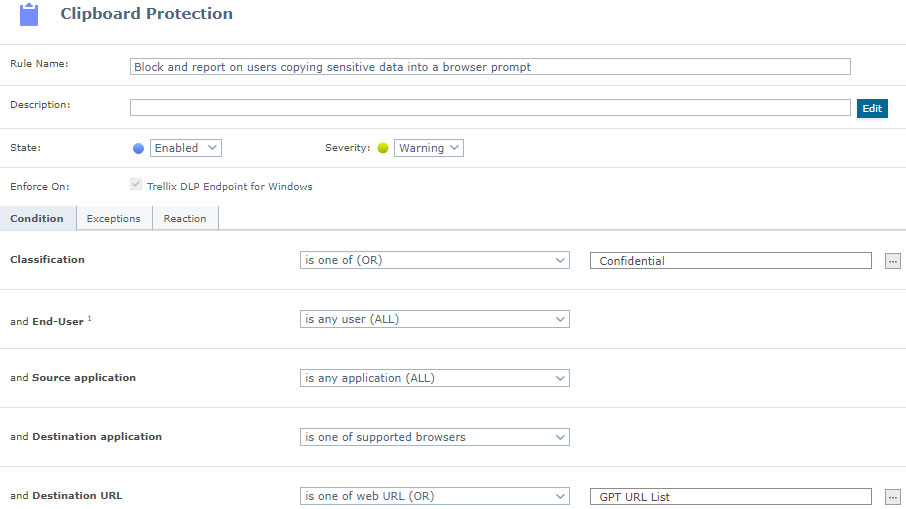

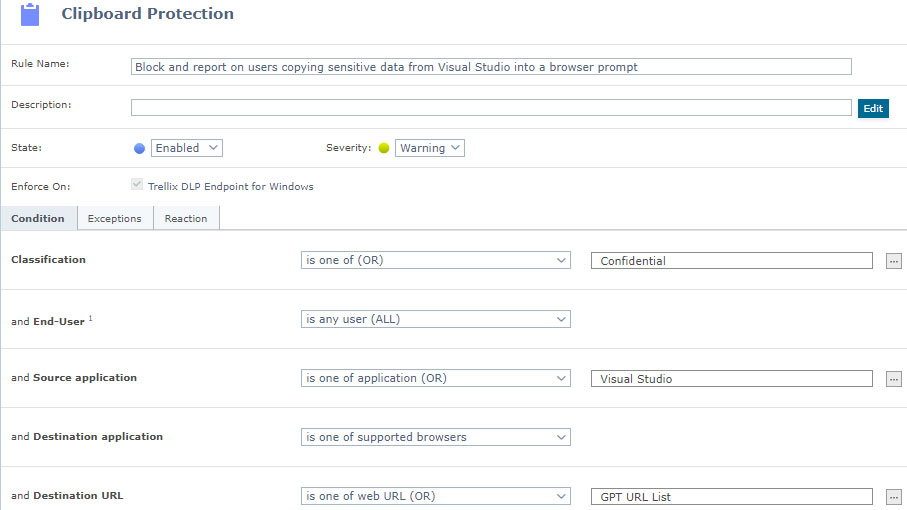

B. Chặn và ghi nhận hành vi copy dữ liệu nhạy cảm vào prompt trình duyệt

- Loại rule: Clipboard Protection

- Enforced On: Windows (macOS chỉ reporting)

- Classification: nội dung nhạy cảm

- End-User: All

- Source Application: All

- Destination Application: Supported Browsers

- Destination URL: GPT URL List

Hình 4: Quy tắc DLP để chặn và báo cáo dữ liệu được sao chép vào lời nhắc trình duyệt

C. Chặn và ghi nhận hành vi copy dữ liệu nhạy cảm từ Visual Studio vào prompt

- Loại rule: Clipboard Protection

- Enforced On: Windows (macOS chỉ reporting)

- Classification: nội dung nhạy cảm

- End-User: All

- Source Application: Visual Studio (Application Template) hoặc All (tuỳ phạm vi kiểm soát)

- Destination Application: Supported Browsers

- Destination URL: GPT URL List

Hình 5: Quy tắc DLP để chặn và báo cáo dữ liệu được sao chép từ Visual Studio sang cửa sổ nhắc lệnh của trình duyệt

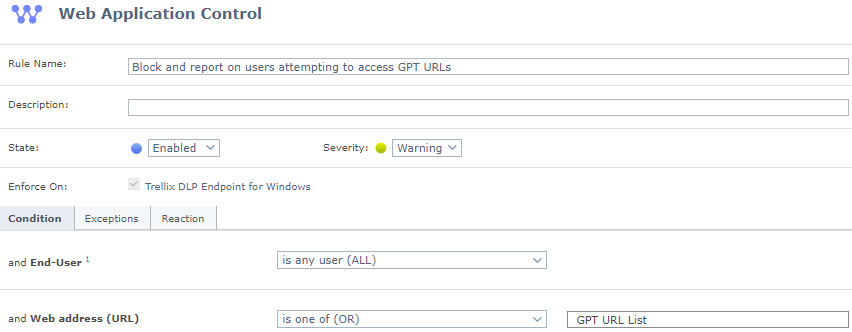

D. Chặn và ghi nhận truy cập tới các URL GPT

- Lưu ý: Web Application Control hiện chỉ hỗ trợ chặn trên Firefox; Chrome và Edge chỉ giám sát và ghi nhận

- End-User: All

- Web Address (URL): GPT URL List

Hình 6: Quy tắc DLP để chặn và báo cáo về người dùng truy cập URL GPT

Lưu ý khi triển khai DLP cho ChatGPT trong môi trường doanh nghiệp

Trong thực tế, việc áp dụng DLP cho ChatGPT không phải là chỉ bật lên một tính năng để chặn dữ liệu, mà cần được thực hiện như một phần trong cách doanh nghiệp quản lý và bảo vệ dữ liệu nói chung. Trước hết, tổ chức cần xác định rõ dữ liệu nhạy cảm và các ngữ cảnh sử dụng AI được phép. Các rule DLP nên được triển khai theo lộ trình từ giám sát sang chặn, nhằm tránh ảnh hưởng đột ngột đến trải nghiệm và hiệu suất làm việc của người dùng.

Bên cạnh yếu tố kỹ thuật, doanh nghiệp cũng cần truyền thông rõ ràng về chính sách sử dụng AI, giúp nhân viên hiểu rằng DLP không nhằm hạn chế sáng tạo, mà để bảo vệ tài sản thông tin và giảm thiểu rủi ro rò rỉ dữ liệu khi ứng dụng AI tạo sinh.

Đọc thêm: Giải pháp Data Loss Prevention: Bảo vệ dữ liệu doanh nghiệp khỏi những rủi ro thất thoát

Điều kiện tiên quyết khi áp dụng rule

Các rule trên giả định doanh nghiệp đã có:

- Chương trình bảo vệ dữ liệu (Data Protection Program)

- Phân loại dữ liệu phù hợp

- Quy trình kiểm thử rule trước khi triển khai production

Việc áp dụng DLP khi sử dụng ChatGPT chỉ thực sự hiệu quả khi các rule được kiểm thử kỹ lưỡng và điều chỉnh phù hợp với môi trường thực tế.

Kết luận

Rủi ro từ ChatGPT là lời nhắc để doanh nghiệp tăng cường quản trị dữ liệu, thay vì hạn chế AI. Doanh nghiệp cần xác định dữ liệu nhạy cảm, xây dựng quy tắc sử dụng AI và triển khai các kiểm soát kỹ thuật phù hợp. Trellix DLP hỗ trợ biến chính sách thành hành động thông qua việc giám sát và kiểm soát dữ liệu theo clipboard, web và ứng dụng. Nhờ đó, doanh nghiệp có thể giảm thiểu rủi ro rò rỉ dữ liệu liên quan đến việc sử dụng ChatGPT một cách thực tế và bền vững.

Liên hệ ngay Mi2 – nhà phân phối chính thức của Trellix tại Việt Nam để được tư vấn cách kiểm soát rủi ro khi ứng dụng AI và xây dựng chiến lược bảo vệ dữ liệu phù hợp với nhu cầu của doanh nghiệp.