Phát triển AI/ML an toàn trên môi trường Điện toán đám mây với Rapid7 InsightCloudSec

Đã hơn một năm kể từ khi ChatGPT xuất hiện, và trong khoảng thời gian đó, thế giới đã trải qua một cuộc cách mạng. Trí tuệ nhân tạo và học máy đã thay đổi cách chúng ta sống, làm việc và giao tiếp. Những tiến bộ này không chỉ giúp máy móc hiểu ngôn ngữ tự nhiên, mà còn cho phép chúng tạo ra văn bản mượt mà, và đôi khi thậm chí vượt qua khả năng của con người.

Khi xã hội đón nhận những tiến bộ này, tác động của Generative AI và LLMs đã tác động đến nhiều lĩnh vực. Chúng xuất hiện trong giao tiếp hàng ngày, sáng tạo nội dung, giáo dục và nhiều hơn thế nữa.

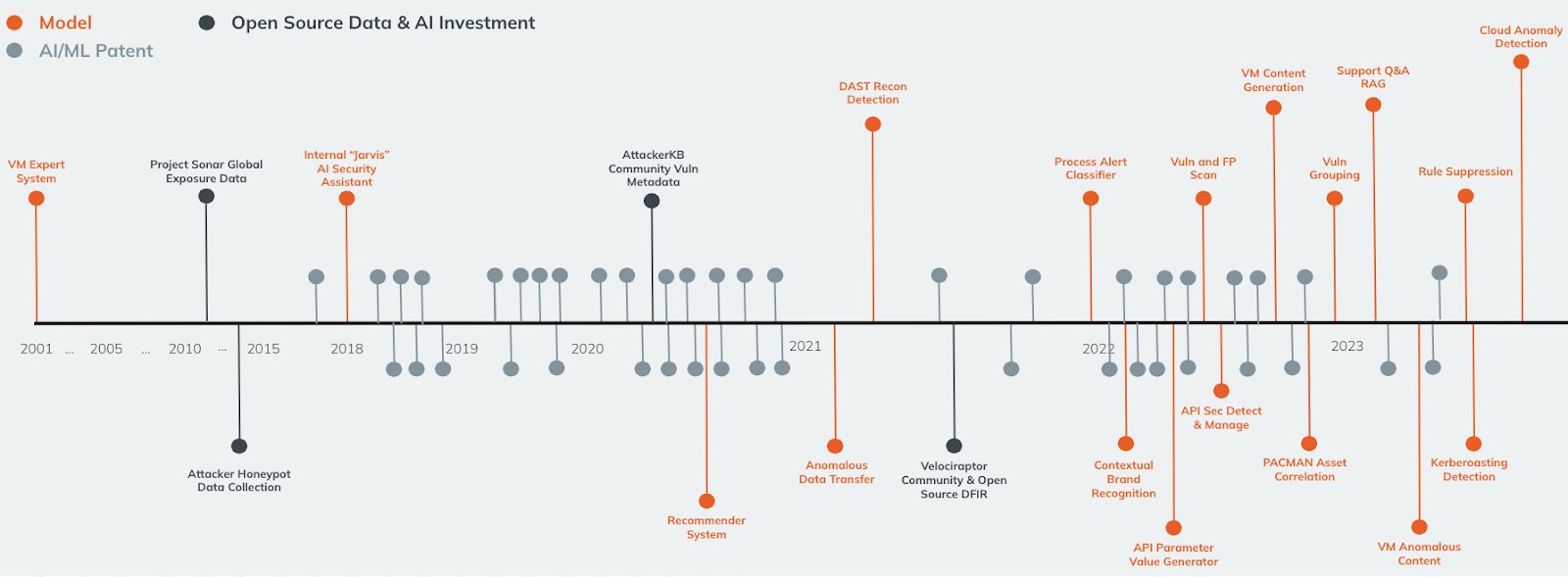

Rapid7: Tiên phong trong lĩnh vực AI cho bảo mật từ những năm 2000

Việc áp dụng AI/ML không được kiểm soát tạo ra rủi ro tiềm ẩn cho bảo mật của tổ chức

Trong bối cảnh này, doanh thu từ dịch vụ trí tuệ nhân tạo đã tăng đáng kể. Các nhà cung cấp dịch vụ đám mây đang đầu tư mạnh vào việc phát triển khả năng của họ. Bằng cách tùy biến các mô hình nền tảng hiện có với dữ liệu huấn luyện riêng, họ cải thiện hiệu suất và trải nghiệm của khách hàng. AWS, Azure OpenAI Service và GCP Vertex AI đều đang đưa ra các giải pháp mới để đáp ứng nhu cầu ngày càng tăng về trí tuệ nhân tạo.

Trí tuệ Nhân tạo/Học máy (AI/Machine Learning – ML) đang ngày càng phổ biến với dự đoán giá trị thị trường sẽ vượt 1.8 nghìn tỷ USD vào năm 2030. Công nghệ này đóng vai trò quan trọng trong việc phát hiện và phân tích mối đe dọa, phát hiện sự xâm nhập bất thường, phân tích hành vi và ứng phó sự cố. Ước tính một nửa số tổ chức đang sử dụng AI/ML, nhưng chỉ 10% có chính sách quản lý việc sử dụng nó.

Các sự cố bảo mật do áp dụng AI/ML không được kiểm soát ngày càng phổ biến, gây tổn hại cho danh tiếng và lòng tin của khách hàng đối với tổ chức.

Việc áp dụng AI/ML nhưng không có chính sách bảo mật cẩn thận dẫn đến tiềm ẩn nhiều rủi ro bảo mật đáng kể. Việc thiếu đi sự giám sát toàn diện có thể dẫn đến vi phạm quyền riêng tư, không tuân thủ quy định, và kết quả của mô hình bị sai lệch, gây ra những kết quả không có tính xác thực. Nếu tổ chức không kiểm tra đầy đủ, mô hình AI sẽ rất dễ bị tấn công, và việc thiếu giám sát vào thời điểm thích hợp có thể dẫn đến sự sai lệch của mô hình (model drift), ảnh hưởng đến hiệu suất của tổ chức theo thời gian.

Đọc thêm: Những nguyên tắc cơ bản về bảo mật đám mây

Phát triển AI/ML an toàn trên môi trường điện toán đám mây yêu cầu khả năng quan sát và phòng thủ hiệu quả

Để giải quyết những mối lo ngại này, các tổ chức nên thiết lập các khung quản trị mạnh mẽ, bao gồm bảo vệ dữ liệu, giảm thiểu sai lệch, đánh giá bảo mật và giám sát tuân thủ liên tục để đảm bảo triển khai AI/ML có trách nhiệm và an toàn. Biết được những gì đang tồn tại trong môi trường của bạn là bước đầu tiên, và chúng ta đều biết việc đó khó khăn như thế nào.

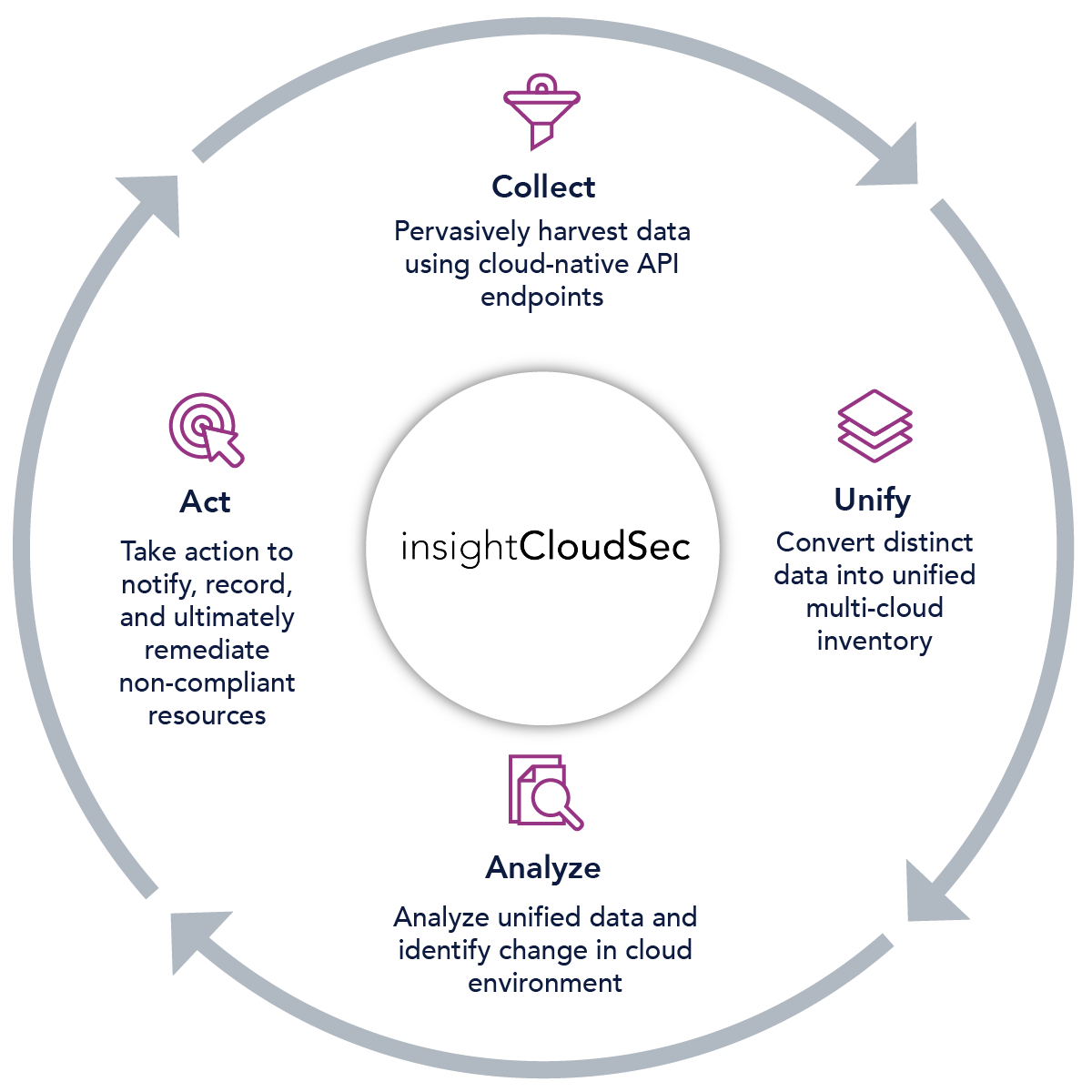

Vì vậy, Mi2 giới thiệu InsightCloudSec – một trang quản lý chuyên biệt được thiết kế dành riêng cho việc quản lý hiệu quả các tài sản AI/ML của tổ chức bạn. Bao gồm một loạt các dịch vụ đa dạng, từ việc kiểm duyệt nội dung và dịch thuật đến tùy chỉnh mô hình, nền tảng của Rapid7 hiện bao gồm hỗ trợ cho Generative AI trên AWS, GCP và Azure.

Khi bạn đã có tầm nhìn tổng quan về các dự án AI/ML đang chạy trong môi trường đám mây của mình, bước tiếp theo là thiết lập các cơ chế để liên tục thực thi một số quy tắc và chính sách để đảm bảo phát triển theo cách an toàn.

Giới thiệu Bộ thực tiễn về bảo mật AI/ML tốt nhất của Rapid7

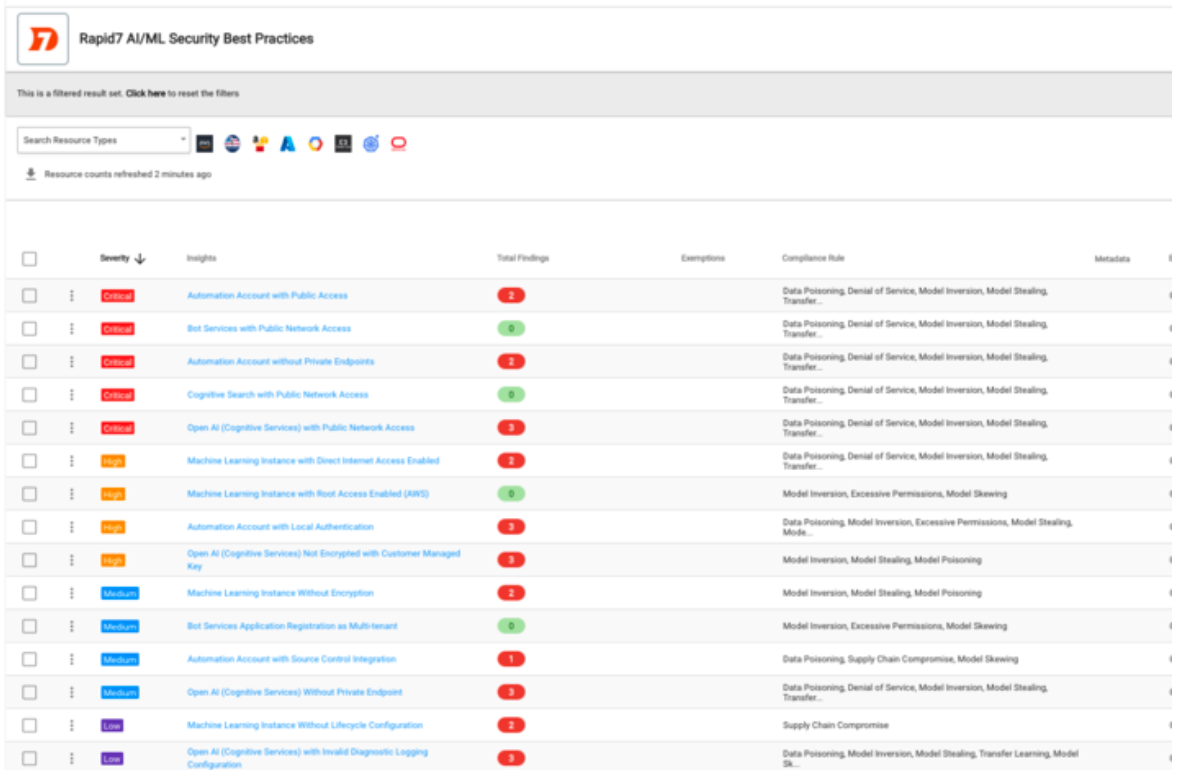

Chúng tôi rất vui mừng được giới thiệu bộ tuân thủ mới nhất trong InsightCloudSec: Bộ thực tiễn tốt nhất về bảo mật AI/ML do Rapid7 cung cấp. Bộ tài liệu này được xây dựng dựa trên 10 Lỗ hổng Hàng đầu của OWASP dành cho Học máy, 10 Lỗ hổng Hàng đầu của OWASP dành cho Mô hình Ngôn ngữ Lớn (LLM) và các đề xuất bổ sung dành riêng cho Nhà cung cấp Dịch vụ Đám mây (Cloud Service Provider – CSP).

Với bộ tài liệu này, bạn có thể dễ dàng kiểm tra xem các hoạt động AI/ML của mình có tuân theo kiểm soát hay không. Điều này cung cấp cho bạn một cái nhìn toàn diện về tình trạng tuân thủ của mình, giúp bạn đưa ra các quyết định và kế hoạch chiến lược tốt hơn. Bên cạnh đó, bạn cũng có thể thiết lập các cảnh báo và khắc phục tự động để phát hiện và ngăn chặn các vấn đề tiềm ẩn trên đám mây.

Bộ tài liệu này bao gồm 11 thuật ngữ liên quan đến tấn công và sử dụng mô hình học máy nhằm tăng sự nhận biết để kiểm soát, tập trung vào bảo mật dữ liệu và mô hình:

| Data Poisoning:

Bỏ dữ liệu độc hại vào tập dữ liệu huấn luyện để điều khiển cách thức hoạt động của mô hình, khiến nó dự đoán sai. |

Model Poisoning:

Bỏ mã độc vào mô hình để tác động đến cách mô hình hoạt động và kiểm soát chúng. |

Model Stealing:

Kẻ tấn công đánh cắp kiến thức hoặc thông tin chi tiết về mô hình học máy đã được huấn luyện. Sử dụng mô hình đánh cắp cho mục đích riêng, chẳng hạn như phân loại dữ liệu hoặc tạo mô hình giả mạo. |

| Model Inversion:

Kẻ tấn công cố gắng hiểu cách thức hoạt động của mô hình học máy bằng cách phân tích đầu vào và đầu ra của nó. Tìm ra điểm yếu của mô hình hoặc sử dụng kiến thức học được để tấn công hệ thống. |

Transfer Learning:

Kỹ thuật tận dụng kiến thức học được từ một mô hình đã được huấn luyện cho một nhiệm vụ khác để giải quyết một nhiệm vụ mới. |

Model Skewing:

Kẻ tấn công thao túng phân phối dữ liệu được sử dụng để huấn luyện mô hình học máy. Làm sai lệch kết quả của mô hình theo hướng có lợi cho kẻ tấn công. |

| Excessive Permissions:

Vai trò và chính sách quá dễ dãi có thể dẫn đến thao túng hệ thống, dịch vụ và mô hình dữ liệu. |

Denial of Service:

Kẻ tấn công cố gắng ngăn chặn người dùng hợp pháp truy cập vào dịch vụ hoặc tài nguyên bằng cách quá tải hệ thống với các yêu cầu. Gây gián đoạn hoặc làm tê liệt dịch vụ. |

Supply Chain Compromise:

Kẻ tấn công lây nhiễm phần mềm độc hại vào các thư viện phần mềm của bên thứ ba được sử dụng bởi hệ thống hoặc dữ liệu. |

| Membership Inference:

Kẻ tấn công phân tích dữ liệu đầu ra của mô hình học máy để xác định hoặc suy luận thông tin nhạy cảm như PII và PHI (Thông tin sức khỏe cá nhân và Thông tin nhận dạng cá nhân) về các thành viên trong tập dữ liệu huấn luyện nhạy cảm. |

Output Integrity:

Kẻ tấn công thao túng đầu ra của mô hình học máy để gây ra kết quả sai hoặc lừa dối hệ thống. Gây thiệt hại tài chính, đánh cắp dữ liệu hoặc phá hoại hệ thống. |

Hiện tại, bộ tuân thủ Thực tiễn An ninh AI/ML Tốt nhất của Rapid7 bao gồm 15 lượt kiểm tra trên 6 dịch vụ AI/ML khác nhau và 3 nền tảng (AWS, GCP, Azure). Hỗ trợ cho dịch vụ Amazon Bedrock sẽ được bổ sung vào bản phát hành đầu tiên vào tháng một của Rapid7.

Đọc thêm: INSIGHTCLOUDSEC – Giải Pháp Loại Bỏ Rủi Ro Trên Cloud

Kết luận

Trong thời đại của AI và ML, việc phát triển các ứng dụng AI/ML một cách an toàn trên đám mây là điều cần thiết để đảm bảo sự thành công và tăng trưởng bền vững của tổ chức. Rapid7 InsightCloudSec cung cấp các công cụ và tài nguyên quan trọng để hỗ trợ các tổ chức trong nỗ lực này.

Bằng cách tận dụng tầm nhìn đầy đủ về tài sản AI/ML, thiết lập các biện pháp kiểm soát và quy trình tuân thủ phù hợp, và áp dụng giải pháp tuân thủ thực hành bảo mật AI/ML tốt nhất của Rapid7, các tổ chức có thể giảm thiểu các rủi ro an ninh, bảo vệ danh tiếng và giữ vững niềm tin của khách hàng.

Hãy tận dụng công nghệ AI/ML một cách thông minh và có trách nhiệm để tạo ra giá trị và thành công bền vững trong tương lai.

Để được tư vấn thêm thông tin về các sản phẩm InsightCloudSec của Rapid7, hãy liên hệ ngay với nhà phân phối Mi2 theo thông tin liên hệ:

Công ty Cổ phần Tin học Mi Mi (Mi2 JSC)

🌎 Website: www.mi2.com.vn

📩 Email: [email protected]

Văn Phòng Hà Nội

- Add: 7th Floor, Sannam Building, 78 Duy Tan Str., Dich Vong Hau Ward, Cau Giay Dist., Hanoi, Vietnam.

- Tel: +84-24-3938 0390 | Fax: +84-24-3775 9550

Văn phòng Hồ Chí Minh

- Add: 5th &6th Floor, Nam Viet Building, 307D Nguyen Van Troi Str., Ward 1, Tan Binh Dist., Ho Chi Minh City, Vietnam.

- Tel: +84-28-3845 1542 | Fax: +84-28-3844 6448